Quand j’ai vu que la dernière émission du “code a changé” de Xavier de la Porte portait sur la modération, je me suis empressé de l’écouter. Mais cette fois-ci, j’ai eu l’impression que mon journaliste préféré n’avait pas épuisé le sujet, peut-être aussi pour ne pas importuner ses invités qui sont des industriels de la modération automatisée.

Je me permets donc de consigner dans ce billet mes réserves suite à cette émission en les illustrant avec Bodyguard, l’outil développé par les invités.

Quand le contexte manque

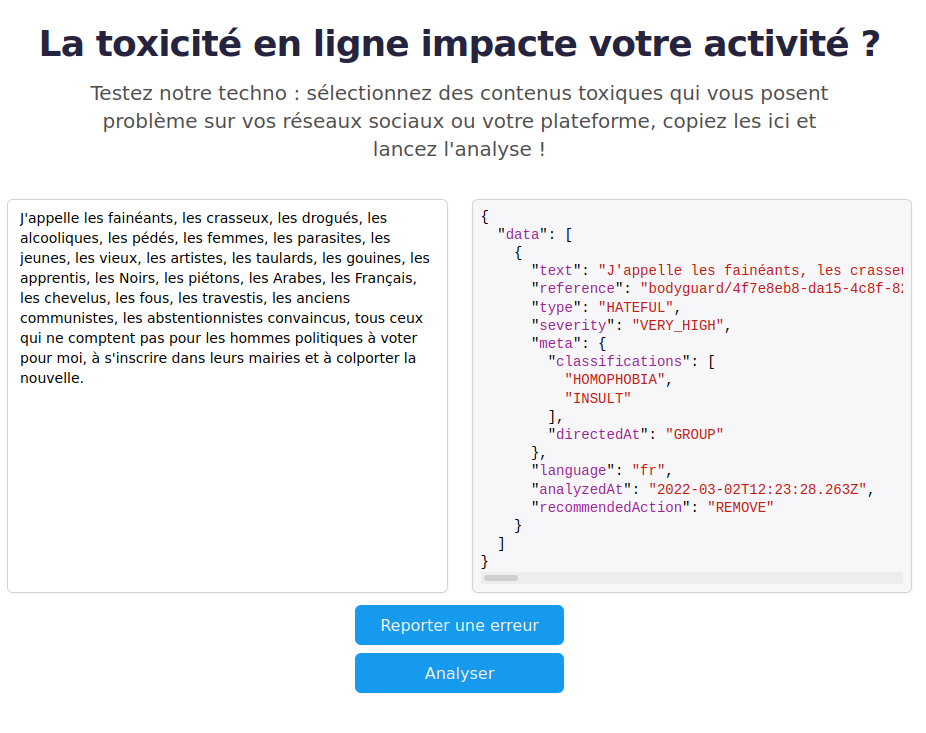

J’ai commencé par copier un extrait de la profession de foi à la présidentielle de Coluche. Résultat : Bodyguard me recommande de supprimer ce message pour cause d’insulte et d’homophobie.

Loin de moi l’idée de crier à la “cancel culture” et le “on ne peut plus rien dire”, mais j’ai l’intime conviction qu’il y a de sérieuses raisons de ne pas censurer ce texte.

Tout d’abord parce que c’est un sujet qui est maintenant source de production scientifique, à l’image du livre Coluche Président. Histoire de la candidature d’un con, et donc ce texte peut être un support d’étude. Peu importe ma position par rapport à ce texte, Bodyguard m’empêche de le partager, en discuter, bref, de l’utiliser comme support dans une discussion, y compris si je veux en faire une critique.

Dans un second temps, il est dur de douter des intentions de l’auteur, y compris en sortant le texte de son contexte, cet inventaire à la Prévert n’a qu’un seul but, dire que qui que vous soyez, aussi marginalisé êtes-vous, vous n’êtes pas représenté par les politiques mais le serez par Coluche“. Bodyguard, malgré tout ses algorithmes, passe complètement à côté de ce sens. D’une certaine manière, dès que la structure de la phrase est un temps soit peu complexe, l’outil est perdu.

C’est le choix des mots, parfois vulgaires, parfois des insultes, parfois racistes ou homophobes, qui a perdu l’outil. Pourtant ce qui est important ici, c’est qui parle, et Coluche a été très clair sur ses engagements à d’autres moments, comme quand il parlait sur un plateau TV des violences policières. Mais ne connaissant pas l’origine du texte, ni le fond de la pensée de Coluche, ni n’identifiant la figure de style (une énumération), l’outil est perdu.

Ce procédé rhétorique utilisé là par Coluche, n’est pas le seul. On peut mentionner par exemple le retournement du stigmate, où quand un groupe de personne s’approprie les insultes à son encontre pour les retourner en les valorisant.

On peut généraliser cette critique au fait que ces outils n’auront jamais accès à l’ensemble du contexte de nos intéractions. En effet ces dernières dépassent largement notre activité en ligne et le cadre du langage. C’est une limite indépassable pour ces outils.

Le racisme contre l’antiracisme

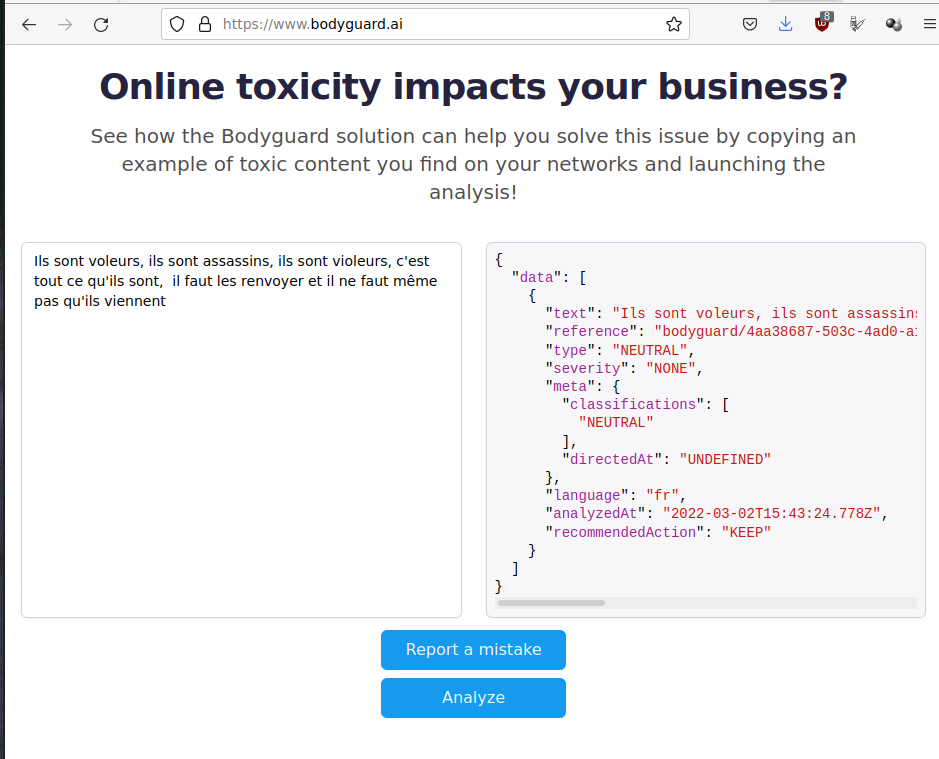

On pourrait se dire que l’outil a ses limites, mais qu’elles ne posent pas de problème, car finalement tout le monde est logé à la même enseigne. Pour ce faire, j’ai comparé les propos de Zemmour, condamné par la loi pour injure raciale et provocation à la haine face à un couplet de Lettre à la République de Kery James, un rappeur.

Les propos de ce dernier ne posent pas de problème selon Bodyguard, qui recommande de garder le message.

Typiquement, dans ce message, le sujet est “les mineurs isolés”. L’affaire a été tant médiatisée que l’on n’a pas besoin de le préciser pour comprendre, mais encore une fois le logiciel n’a pas ce contexte. C’est une convention entre moi et les autres interlocuteurs qui est utilisée ici, et qui échappe totalement au logiciel.

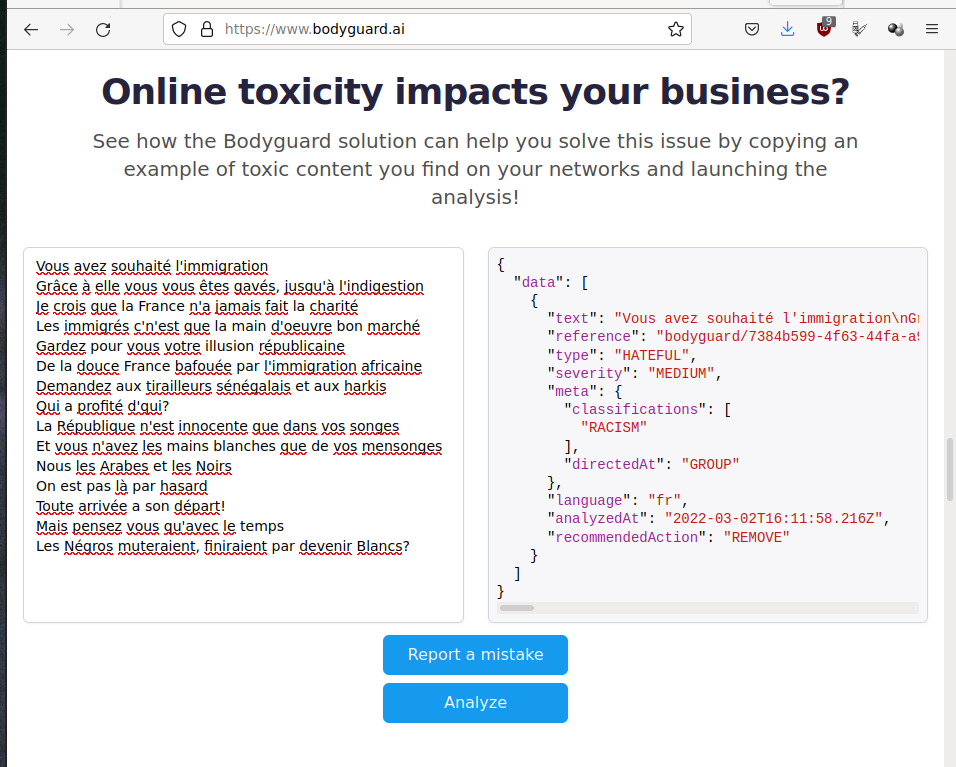

Maintenant si on prend un couplet de “Lettre à la République”, le résultat est complètement différent.

Le message est classé en “Racisme, à supprimer”. Pour le contexte, on parle ici d’un texte largement considéré comme antiraciste. D’ailleurs, si vous voulez situer l’auteur, il a réalisé un film en prolongement de cette chanson.

De ce petit tour, on peut voir qu’être vulgaire dans ses messages et aborder des sujets sensibles, comme le racisme ou l’homophobie, expose à un grand risque de censure, pour peu que la structure des phrases soient un peu complexes.

L’émission en regard de cette analyse

Dans l’émission, il est fait référence à l’acquisition et au traitement de ce contexte d’un point de vue technique : scraping, (u)nlp, veille, profiling, etc. Mais ce travail est réalisé exclusivement par l’entreprise. Et il n’est jamais fait de lien entre tout ces procédés techniques. En découle de cette présentation, l’impossibilité de conclure que l’outil a une limite indépassable sur le plan théorique : puisqu’il n’aura jamais accès à toutes nos intéractions, il ne pourra jamais pleinement comprendre le contexte autour d’un message.

Si je suis partisan de laisser la question de la modération aux humains, il est possible de penser un meilleur usage de ces outils aussi. Par exemple, en donnant la possibilité de faire appel des décisions publiquement, on permettrait de limiter l’impact des faux-positifs. Ou encore, en permettant de contribuer manuellement et collaborativement le contexte manquant à l’outil, on pourrait préentivement empêcher des faux-positifs tout en remettant au centre du débat la définition d’un comportement toxique. Par exemple, une critique valide, dite une fois est importante, mais répétée 10 000 fois a un effet toxique.

En conclusion

La modération automatisée n’empêche en rien d’attaquer psychologiquement, de harceler, ou de tenir des propos haineux sur Internet : elle empêche seulement d’utiliser la vulgarité ou de discriminer ouvertement pour le faire, certes deux schémas récurrents du harcèlement, mais qui sont loin de s’y limiter.

Cette modération automatisée se fait au prix de la censure d’autres discours, eux tout à fait légitime, à l’image des revendications de justice sociale.

Je terminerai en paraphrasant Casey, si tu veux dénoncer des rapports de domination, tu dois encore le dire de manière détournée et sans vulgarité, parce qu’il ne faudrait pas déranger.

Comments

No comments yet. Be the first to react!